Google представила метод съёмки и потоковой передачи объёмного видео с таким сжатием, что его можно воспроизводить даже на автономных очках виртуальной реальности. Разумеется, без критических потерь качества.

Сегодняшнее моноскопическое и стереоскопическое видео в формате полной сферы (так называемый формат 360 градусов) имеет недостаток, бросающий тень на саму концепцию. Находясь в таком видео, пользователь инстинктивно хочет перемещаться по нему, поскольку его нервная система отвечает на глубокий эффект погружения. При этом, вы можете вращать головой, смотреть вверх, вниз, влево, вправо, но изменить позицию не получится.

Причиной тому сам формат съёмки: хотя очки давно позволяют гулять по виртуальному миру куда угодно, двигаясь в реальности, видеосферы снимаются в «старом» виде, при котором в файле нет никакой информации об объёме сцены и объектов. Поэтому здесь можно включать только трёхосевой трекинг, оставляя полноценный шестиосевой неопределённому будущему.

Объёмное же видео должно содержать информацию о распространении света в сцене, чтобы пользователи очков виртуальной реальности могли передвигаться относительно её осей координат, продолжая реалистично воспринимать объекты. Конечно, Google далеко не первой высказывает подобную идею, но она делает новые шаги к её потребительской реализации.

В статье, опубликованной в преддверии конференции SIGGRAPH 2020, исследователи Google описали создание массива их 46 синхронизированных экшн-камер, закреплённых на куполе диаметром 92 сантиметров. Система даёт пользователю возможность смены позиции на 80 сантиметров, а также обеспечивает угловое разрешение 10 пикселей на градус, поле зрения более 220 градусов и запись видео со скоростью 30 кадров в секунду.

Исследователи говорят, что установка может реконструировать объекты на расстоянии всего 20 сантиметров от камеры благодаря новому алгоритму интерполяции в системе глубокого обучения Google DeepView.

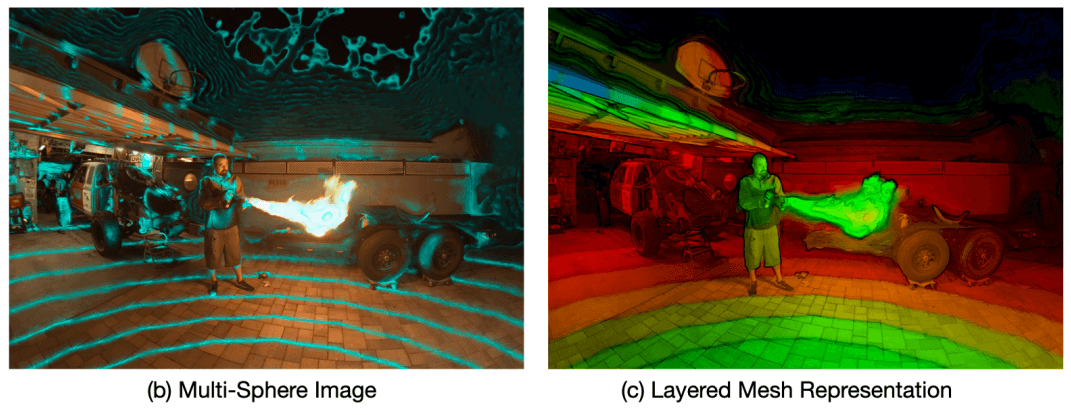

Это делается путём замены базового многоплоскостного представления сцены набором сферических оболочек, которые лучше подходят для представления содержимого панорамного светового поля.

Мы дополнительно обрабатываем данные, чтобы урезать большое количество оболочек-слоёв до небольшого фиксированного числа слоев RGBA+глубины без существенной потери качества изображения. Получающиеся в результате RGB-, альфа- и глубинные каналы в этих слоях затем сжимаются с использованием традиционных методов текстурного наложения и видеокомпрессии. Окончательное сжатое представление мало весит и может отображаться на мобильных платформах виртуальной и дополненной реальности или в веб-браузере, — заключают сотрудники Google.

Решение может оказаться эффективным и с точки зрения ресурсов на производство, и с точки зрения ресурсов на воспроизведение. Технология найдёт широкую поддержку (или быструю проверку гипотезы) среди создателей контента, если американская корпорация поддержит её в своих сервисах, таких как YouTube.

Подробности проекта есть в оригинальной статье. Хотите много примеров объёмного видео от Google? Они здесь.

Не пропускайте важнейшие новости о дополненной, смешанной и виртуальной реальности — подписывайтесь на Голографику в Telegram, ВК, Twitter и Facebook!

Далее: Facebook представила прототип тонких ВР-очков с голографической оптикой