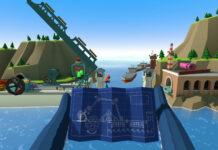

Geenee, разработчик low-code-платформы для создания браузерной дополненной реальности, соединил свой SDK для отслеживания тела с генеративным искусственным интеллектом Stable Diffusion. Хотя применений такого у подхода может быть много, компания выбрала моду: уникальная цифровая одежда создаётся прямо на человеке, и для этого даже не нужно специальное приложение.

В последние пару лет вошли в моду нейросетевые модели для генерации изображений по текстовым описаниям, такие как DALL-E 2, Midjourney и Stable Diffusion. Они упрощают создание графических элементов, заменяя авторское творчество на конвейер.

Geenee объединила свой браузерный трекинг тела с моделью Stable Diffusion, получив на выходе почти мгновенный генератор нарядов. Им далеко до реализма, особенно по задержкам, зато порог входа в автогенерацию одежды снизился до браузера на телефоне (или, например, очень простого стенда в магазине).

Пользователь может вводить любую фразу и получает текстуру, накладываемую на него в реальном времени. Дополнительно можно применить различные настройки изображения.

В качестве вариантов применения Geenee рассматривает маркетинговые кампании, токенизированную одежду и настройку аватаров в играх и метаверсах.

Не пропускайте важнейшие новости о дополненной и виртуальной реальности — подписывайтесь на Голографику в Telegram, ВК и Twitter! Поддержите проект на Boosty.

Далее: API Body Tracking для Quest не умеет отслеживать всё тело, несмотря на название и рендеры