Исследователи Facebook нашли способ использовать машинное обучение, чтобы дать приложениям Oculus Quest на 67% больше производительности на графических процессорах. В компании подчёркивают, что пока это «просто исследование». А ещё это способ поддержать продажи Quest, но, если всё получится, не самое свежее железо этих очков получит весомый апдейт.

Аннотация к исследованию:

В этой статье мы обсуждаем фреймворки для выполнения алгоритмов машинного обучения в графическом конвейере мобильной виртуальной реальности для повышения производительности и качества изображения в реальном времени. Мы анализируем и сравниваем преимущества и издержки различных возможностей. Мы проиллюстрируем силу использования машинного фреймворка в графическом конвейере с применением эффективного пространственно-временного увеличения разрешения, которое увеличивает мощность рендеринга графического процессора ради лучшего качества изображения.

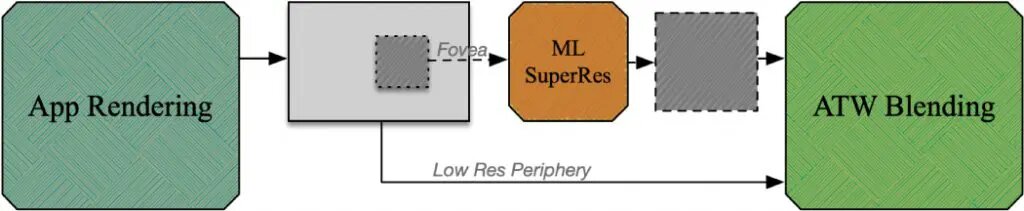

Новая техника рендеринга предполагает, что он производится при более низком разрешении, чем обычно, а затем центр поля зрения масштабируется с использованием так называемого алгоритма «суперразрешения». Он увеличивает разрешение кадра, делая собственные выводы о том, как дополнить изображение, на основании полученного опыта.

Алгоритмы такого типа обрели широкую популярность в последние годы. Их простой реализацией являются сайты, которые предлагают «улучшить качество» фото. В случае Facebook, алгоритм должен встраиваться в графический конвейер и работать в реальном времени.

При наличии достаточного количества обучающих данных подобные алгоритмы могут производить значительно более детальную доработку, чем традиционный апскейлинг. Результат основан на предположениях алгоритма и предполагает ошибки, но во многих случаях на практике они незаметны.

Стоит отметить, что одним из авторов статьи является Бехнам Бастани (Behnam Bastani), руководитель отдела графики Facebook в отделе Core AR/VR Technologies. С 2013 по 2017 год Бастани работал в Google, разрабатывая «передовые системы отображения», а затем возглавлял разработку конвейера рендеринга Daydream.

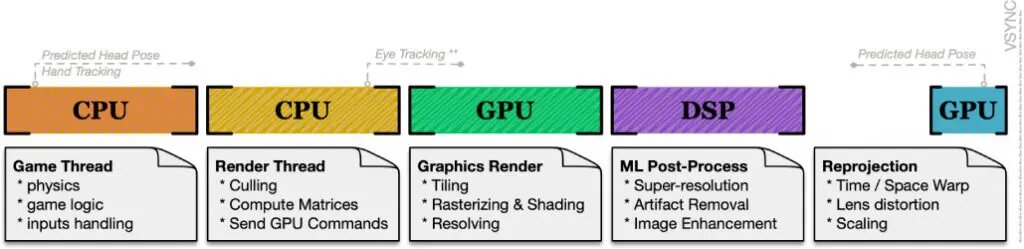

На самом деле, в статье исследователи сосредоточились не на алгоритме или высвобождении ресурсов графического процессора. Прямая цель исследователей состояла в том, чтобы создать технологическую базу для запуска алгоритмов машинного обучения в реальном времени в рамках текущего конвейера рендеринга с низкой задержкой. Повышение разрешения является лишь примером вытекающих преимуществ.

Авторы говорят, что им удалось добиться «согласованных во времени и визуально приятных результатов». При рендеринге с разрешением на 70% ниже нормы в каждом направлении, метод может сэкономить примерно 40% времени графического процессора, и разработчики могут «использовать эти ресурсы для создания лучшего контента».

В таких приложениях, как браузер мультимедийных файлов, сохранённую мощность графики можно оставить в покое для увеличения времени автономной работы, поскольку на чипах Snapdragon (и большинстве других) DSP для задач машинного обучения намного эффективнее, чем графический процессор.

Ограничением этого метода является то, что он может добавить задержку, поскольку дополнение происходит после обработки кадра. Но мобильная графика отличается от процессоров ПК способностью исполнять задачи NPU асинхронно, поэтому масштабирование можно выполнять для каждой плитки, добавляя к ней лишь несколько миллисекунд задержки.

Демонстрационное видео создано в Beat Saber. Левое изображение сгенерировали с использованием нейросети, которая работает с вдвое меньшим разрешением, а правое является результатом обычного рендеринга:

Исследователи также объяснили, как их разработку можно применить к новым очкам:

Другим преимуществом реконструкции на основе машинного обучения является уменьшение задержки и запаздывания в системе рендеринга с отслеживанием глаз. С предложенной архитектурой система рендеринга не должна знать, куда смотрит глаз, и рендерить с одинаковым низким разрешением. После рендеринга фовеальная область, определяемая системой слежения за глазами, реконструируется с помощью моделей машинного обучения и смешивается с периферийными областями в композере. Таким образом, время от движения до отклика можно уменьшить примерно на одну длительность кадра минус немного времени на ML-реконструкцию. Такое сохранение задержки может быть критическим для некоторых систем слежения за глазами, которые позволяют избежать артефактов задержки с помощью саккад.

Помимо применения для увеличения разрешения, платформу также можно использовать для удаления артефактов сжатия для потокового контента, прогнозирования кадров, анализа характеристик и обратной связи для управляемого фовеального рендеринга. Мы верим, что использование вычислительных методов и машинного обучения в конвейере мобильной графики откроет перед нами множество возможностей для мобильной графики следующего поколения.

С подробностями можно познакомиться в оригинальной научной публикации.

Не пропускайте важнейшие новости о дополненной, смешанной и виртуальной реальности — подписывайтесь на Голографику в Telegram, ВК, Twitter и Facebook!

Далее: NVIDIA ускорила виртуальную реальность особым суперсэплингом