Мы пока не создали по-настоящему разумный искусственный интеллект, но постоянно учим компьютеры видеть, читать и понимать наш мир. В прошлом месяце инженеры Google впервые продемонстрировали программное обеспечение Deep Dream, способное узнавать, что именно находится на изображениях. И сразу за этим учёные Стэнфордского университета рассказали об исследовании, в рамках которого разработали похожий софт под названием NeuralTalk, который может анализировать визуальные образы и описывать их с почти пугающей точностью.

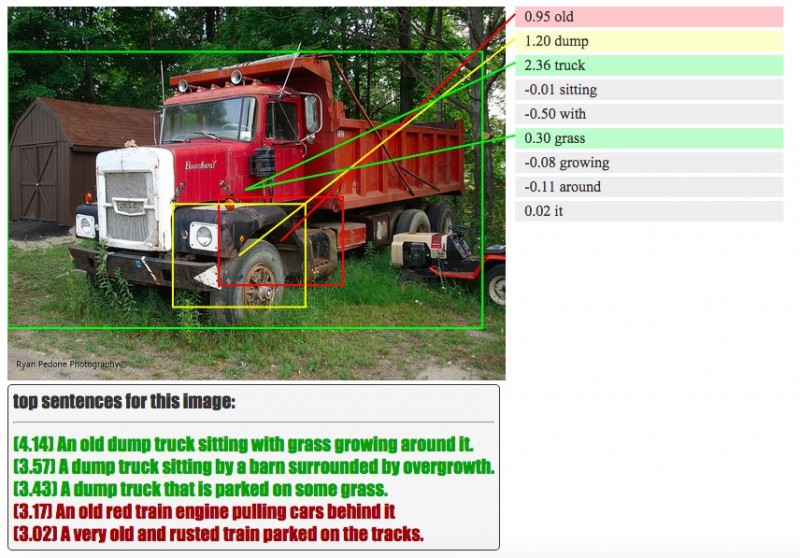

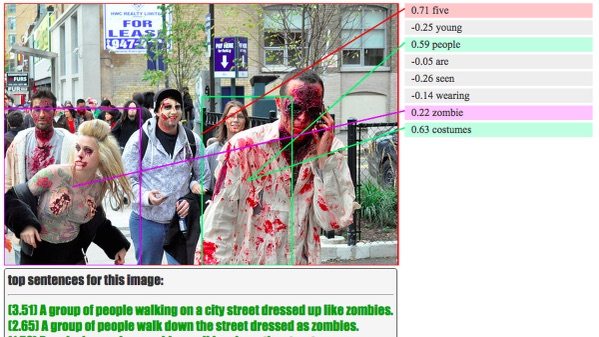

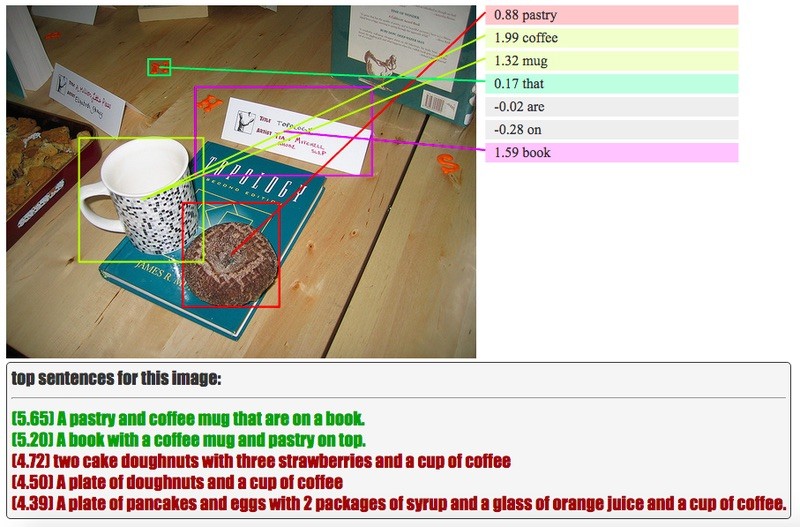

Впервые опубликованные в прошлом году, программа и сопутствующее исследование стали результатом работы директора Стэнфордской лаборатории искусственного интеллекта Фей-Фей Ли (Fei-Fei Li) и аспиранта Андрея Карпатного (Andrej Karpathy). Программа может идентифицировать происходящее в сложных сценах. Например, изображение с человеком в чёрной рубашке, играющим на гитаре, оно помечало как «человек в чёрной рубашке играет на гитаре». Изображения прыгающей через перекладину чёрно-белой собаки, человека, занимающегося сёрфингом в синем гидрокостюме, и девочки, которая ест торт, также были описаны одним поражающе точным предложением.

Как и Deep Dream, проект из Стэнфорда использует для обработки нейронную сеть, сравнивает новое с тем, что уже видел, и описывает их максимально приближённым к естественному человеческому языком. Нейронные сети созданы похожими на человеческий мозг и работают по-детски. Это значит, что их нужно учить основам реального мира — как выглядит окно, стол, кот, что происходит на разных картинках, и так далее, — после чего сеть начинает самостоятельно разбираться с новыми изображениями или видео.

Работа NeuralTalk далека от совершенства. Взрослая женщина, осторожно держащая огромный пончик, помечается как «Маленькая девочка, водящая феном на головой», а любопытный жираф называется собакой, выглядывающей из окна. Весёлая пара с праздничным тортом в саду получает заголовок «Человек в зелёной рубашке рядом со слоном», и куст при этом выступает в роли слона, а торт в роли человека. Но в большинстве случаев такие расшифровки являются вторичными догадками. Например, наряду с описанием слона, программа также определяет пару с тортом как «Женщина, стоящая с краю и держащая кокосовый торт, на которую смотрит мужчина».

До недавнего времени визуальные данные в интернете, коих набралось невероятное количество, для адекватной запросам выдачи должны были помечаться вручную. В самом начале своей работы картографический сервис Google опирался на команду из сотрудников компании, которые лично проверяли запросы и выводимые данные, чтобы убедиться в правильности выдачи адресов. Новая задача потребовала подходящего решения, и в конце концов на свет появилось программное обеспечение Google Brain. Для него проверка всей информации Street View из Франции занимает меньше часа, а у людей это заняло бы недели.

Я считаю, что пиксельные данные из изображений и видео являются тёмной материей интернета, — заметил Фей-Фей Ли в интервью New York Times в прошлом году. — Сейчас мы начинаем освещать её.

По теме: Глаза напротив: беседа с Intel о RealSense, разработке и AR/VR-будущем

Энергию для освещения предоставляют гиганты веб-индустрии, такие как Google и Facebook, которые стремятся классифицировать миллиарды фотографий и поисковых запросов. Более ранние исследования сосредоточены на распознавании одиночных объектов (в 2012 году движок Google учился распознавать котов), но учёные утверждают, что это не совсем правильное направление.

Мы сосредоточились на объектах и проигнорировали действия, — сказал New York Times информатик Вашингтонского университета Али Фаради (Ali Farhadi).

Тем не менее более поздние программы сосредоточены на более сложных данных и пытаются научить компьютеры понимать не состав кадра, а происходящее в нём. Стэнфордские учёные могли бы внедрить свой проект с описанием изображений естественным языком в поиск по репозиториям, чтобы вместо просмотра сотен условно подходящих картинок вы сразу получили бы ту, «на которой собака прыгает на диван». Так на YouTube или в Google можно будет получать точно то, что нужно, а не просто контент, подходящий по тегам.

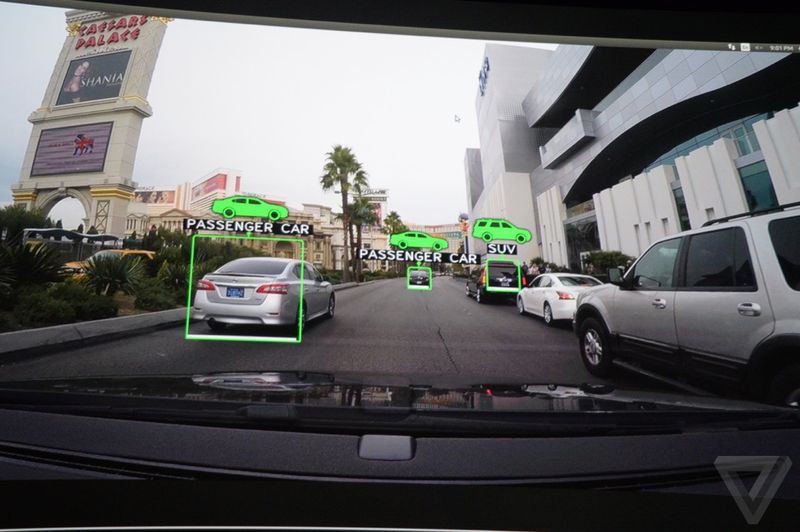

Нейронные сети полезны и в реальном мире. На выставке CES в этом году соучредитель, президент и генеральный директор Nvidia Джен-Сен Хуан (Jen-Hsun Huang) заявил, что её автомобильный «суперкомпьютер» Drive PX включает «глубокую нейронную сеть компьютерного зрения». По его словам, технология позволяет определять опасности во время езды, предупреждать о пешеходах, знаках, спецмашинах и других объектах. Применение нейронной сети в данном случае значит, что Drive PX не требуются эталонные изображения каждого объекта: грубо говоря, если есть колёса, лобовое стекло, решётка радиатора, то это автомобиль, а если руки и ноги — человек. Большие автомобили — грузовые, а если сверху есть проблесковые маячки, то такую машину лучше пропустить. Nvidia приспособила для этого универсальные вычислительные блоки собственных графических решений — тех же, что работают в Стэнфорде.

Поскольку технология применения нейронных сетей в компьютерном зрении должна работать автоматически и независимо, и задача это непростая, занимающиеся её решением компании прибегают к помощи открытых сообществ энтузиастов, таких как GitHub. Таким образом действует код Google Deep Dream, который пытается найти для себя визуальные ориентиры.

Сейчас всё это выглядит как удобный инструмент, обеспечивающий быстрый и точный, но всё-таки обычный поиск по картинкам в интернете. И это так, но что будет, когда нейронные сети начнут разбираться в действиях их создателей? Вопрос открыт.

Далее: BMW 5 получат HUD с дополненной реальностью в следующем году

По материалам The Verge и Стэнфордского университета (1, 2, 3)